我所师生参加LREC-COLING 2024国际会议

作者:yifan时间:2024-06-11

计算语言学领域的两大国际组织--欧洲语言资源协会(ELRA)和国际计算语言学委员会(ICCL)联合组织了2024年计算语言学、语言资源和评估联合国际会议(LREC-COLING 2024),会议于2024年5月20-25日在意大利都灵举行。

LREC和COLING均是具有悠久历史的国际会议,LREC迄今已举办了15届,COLING则举办了30届,两大会议均是两年举办一次。其中,COLING是CCF推荐的B类国际会议。

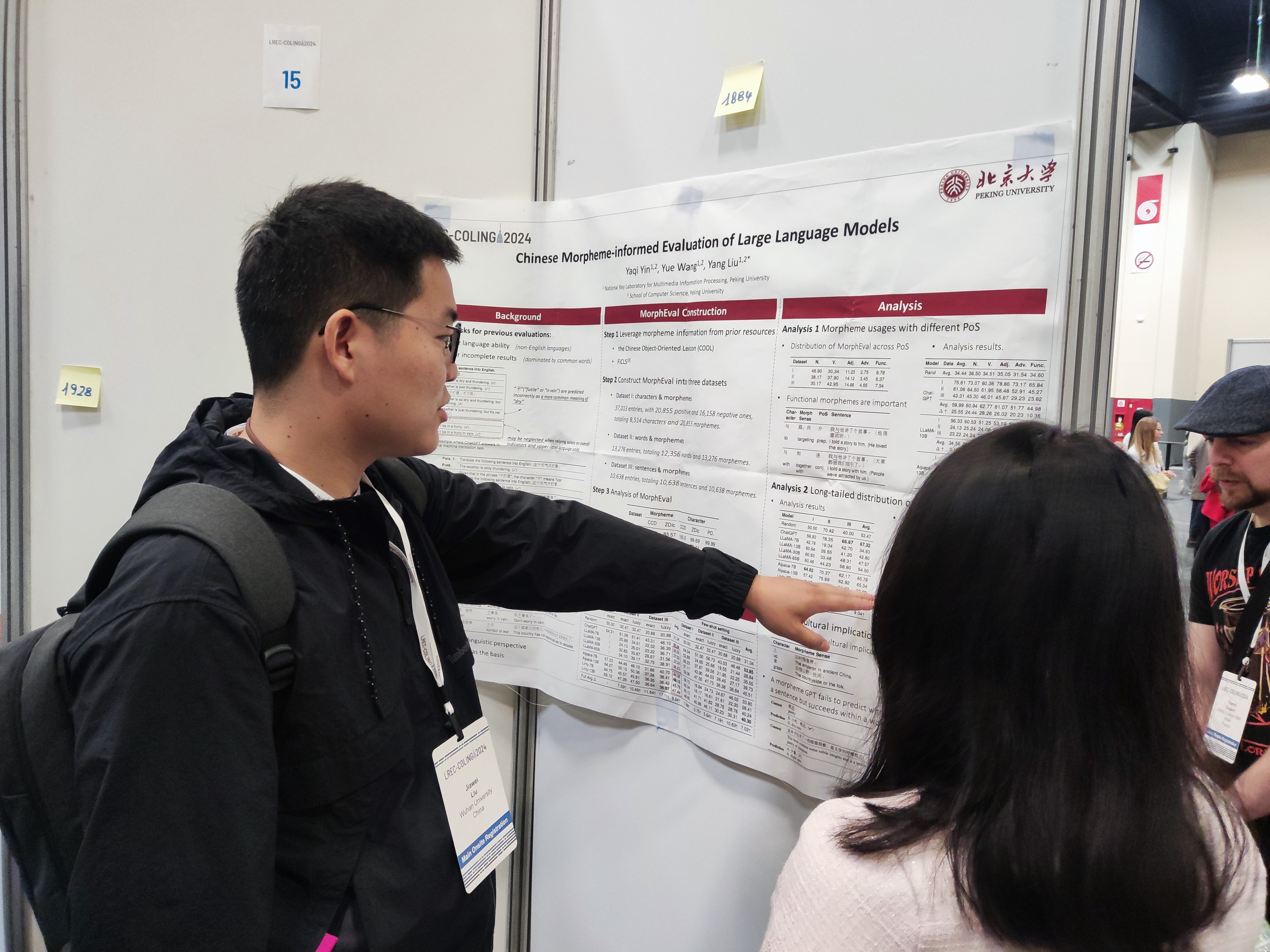

这次两大会议的联合召开,吸引了来自83个国家和地区的2000余名计算语言学、语音、多模态和自然语言处理领域的研究人员和从业人员参加,会议通过特邀报告、口头报告和海报展示,为与会者提供了充分的学术碰撞和交流机会。我所硕士生熊资、博士后刘家伟分别以线上、线下方式参加了此次盛会。

本次会议,我所与阿里巴巴通义实验室、伍斯特理工学院合作的论文“Enhance Robustness of Language Models Against Variation Attack through Graph Integration”被录用并做口头报告。预训练语言模型(PLMs)在自然语言处理(NLP)中的广泛使用极大地提高了性能成果。该论文主要探索了针对中文预训练语言模型的字符变异攻击识别。当前,预训练语言模型(PLMs)在自然语言处理(NLP)任务中被广泛使用。这些模型对对抗性攻击的脆弱性,尤其是在中文语言中,由于其丰富的字符多样性/变化和复杂结构,引发了各界严重的担忧。为了解决这个问题,我们提出了一种新的方法,名为CHinese vAriatioN Graph Enhancement (CHANGE),以增强PLMs对抗中文内容中字符变化攻击的鲁棒性。CHANGE方法通过将中文字符变化图集成到PLMs中,通过设计不同的补充任务利用图结构,本质上增强了PLMs对抗被操纵文本的解释能力。在多种NLP任务中进行的实验表明,CHANGE在对抗对抗性攻击方面优于当前的语言模型,并且对鲁棒语言模型研究做出了有价值的贡献。该论文还讨论了与鲁棒中文语言模型和知识图谱增强的PLMs相关的工作,并详细介绍了中文字符变化图的集成方法。此外,该论文还提出了一种变体图指导的预训练方法,以进一步提高PLMs的有效性。

本次参会不仅展示了我所在计算语言学领域的研究实力,同时也为我们提供了一个宝贵的交流和学习平台。通过与国际同行的深入交流,我们不仅获得了最新的研究动态和技术进展,还建立了许多有价值的学术联系。

文字来源:刘家伟